Novi Dometi AI: Audio API Model Open AI-a

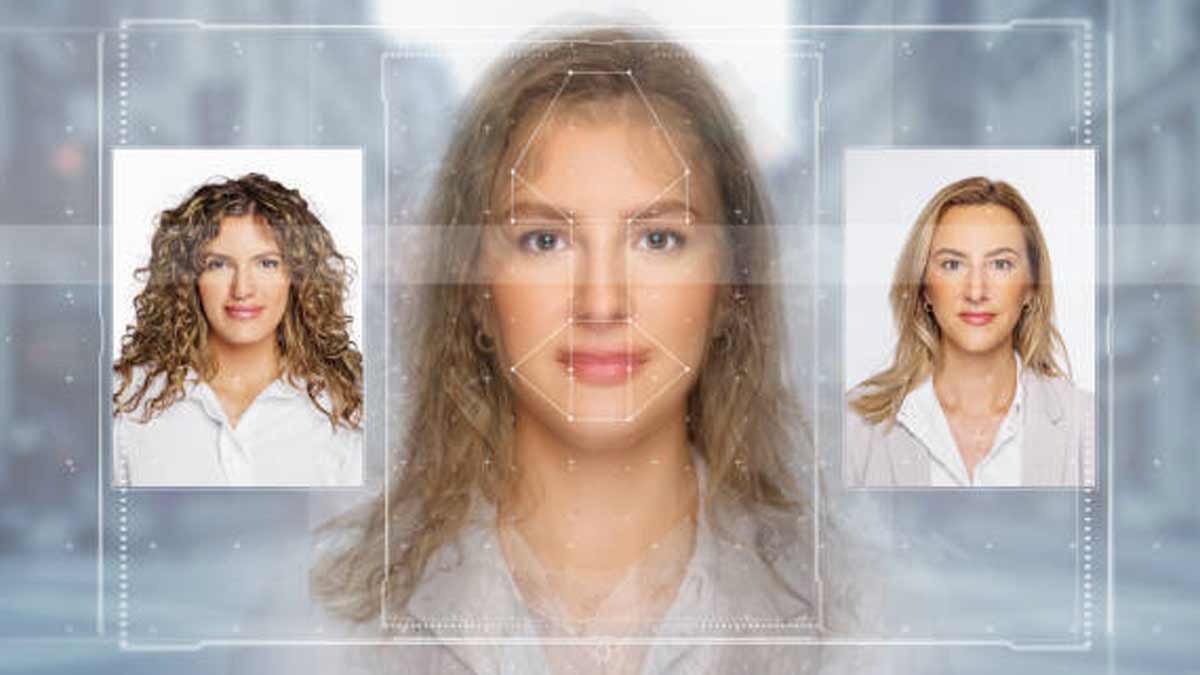

Bitlsi su još jednom osvojili srca miliona fanova svojom najnovijom pesmom, koristeći veštačku inteligenciju (AI) kako bi unapredili kvalitet zvuka i kombinovali delove starih snimaka. Međutim, dok oduševljavamo se ovim tehničkim dostignućem, suočavamo se i sa tamnijim stranama AI – poput stvaranja deepfake snimaka i slika. Nedavno predstavljeni Audio API model kompanije Open AI otvara vrata novim mogućnostima, ali istovremeno postavlja ozbiljna pitanja o potencijalnoj zloupotrebi tehnologije.

Deepfake Glasovi i Sajber Napadi

Audio API model kompanije Open AI nije trenutno sposoban za kreiranje deepfake glasova, ali ukazuje na brz razvoj tehnologije generisanja glasa. Upotreba veštačke inteligencije u prevarama, iako trenutno nije masovna, pokazuje potencijalnu pretnju. Nedavni slučaj američkog investitora Tima Drapera, koji je upozorio na mogućnost korišćenja njegovog glasa u iznudama putem veštačke inteligencije, ilustruje ozbiljnost problema.

Stanje Tehnologije Deepfake Glasova

Današnja tehnologija još uvek ne može proizvesti deepfake glas visokog kvaliteta koji bi bio neprimetan. Međutim, poslednjih meseci svedočimo pojavi više alata za generisanje ljudskog glasa, čime se olakšava kreiranje deepfake materijala. Iako je za sada potrebno određeno programersko znanje, očekuje se da će budući modeli nuditi i kvalitetne rezultate i jednostavnu upotrebu.

Prevencija i Zaštita od Deepfake Glasova

Uprkos trenutnoj retkosti deepfake glasova u sajber pretnjama, brz razvoj tehnologije zahteva preventivne mere. Savetuje se pažljivo slušanje sagovornika putem telefona – loš kvalitet snimka, prisustvo šumova ili robotski zvuk mogu ukazati na prevaru. Postavljanje neočekivanih pitanja može takođe razotkriti veštački generisane odgovore, dok je instaliranje pouzdanih bezbednosnih rešenja još jedan korak ka zaštiti od potencijalnih pretnji.

Naučnik Kaspersky-a Upozorava

Dmitrij Anikin, viši naučnik za podatke u kompaniji Kaspersky, ukazuje na važnost svesti o potencijalnim pretnjama i spremnost na suočavanje sa naprednim deepfake prevarama koje postaju realnost. Osnovni savet je ne preterivati u pretnji, ali ostati obazriv i pripremljen na nove izazove koje tehnologija može doneti.

Budućnost Deepfake Glasova

Iako se deepfake glasovi trenutno ne smatraju značajnom pretnjom, njihov potencijal za zloupotrebu je evidentan. Tehnološki napredak otvara vrata novim rizicima, ali istovremeno zahteva razvoj efikasnih mera zaštite. Pažljiva upotreba tehnologije, svest o pretnjama i investiranje u bezbednosna rešenja predstavljaju ključne korake ka očuvanju integriteta komunikacije u digitalnom svetu.

Više informacija o glasovnim deepfake snimcima dostupno je na ovom linku.